【论文阅读 | TPAMI | IVIF任务进展和应用概述:从数据兼容性到任务适配性】

[TOC]

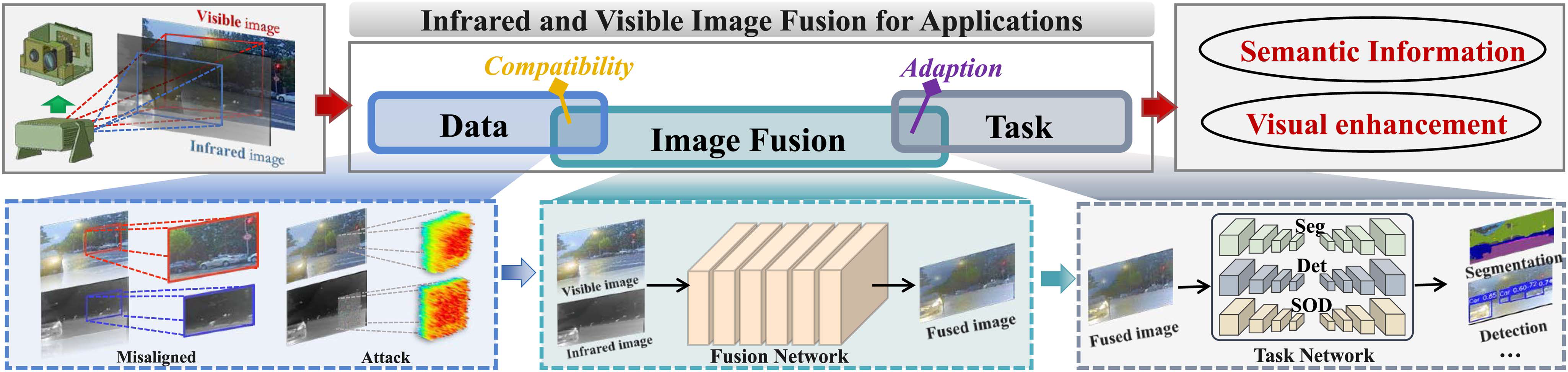

题目:Infrared and Visible Image Fusion: From Data Compatibility to Task Adaption

会议:IEEE Transactions on Pattern Analysis and Machine Intelligence (IEEE TPAMI)

代码:https://github.com/RollingPlain/IVIF_ZOO

时间:23 December 2024

本文将近年来的IVIF方法进行了总结分析,可以将本文当做快速学习IVIF方法的途径

1. 引言:从光谱到 IVIF

1.1 可见光(VIS)与红外(IR)回顾

可见光 VIS

- 传感器记录可见波段的反射光,也就是我们常见的 RGB 图像

- 优点:纹理、颜色、结构信息丰富,细节清晰

- 缺点:高度依赖环境光,在夜晚、逆光、雨雾、烟雾环境下质量急剧下降

红外 IR

- 记录物体表面的热辐射,不依赖可见光

- 优点:弱光 / 全黑环境也能看见“热目标”(行人、车辆等)

- 缺点:纹理少、对比度低,看起来“灰、糊”,不适合直接做人眼视觉展示

典型互补性:

VIS:看清细节、结构

IR:看清重要目标

→ 于是不难想到:把两者融合成一张“既清晰又目标突出的”图像。

1.2 IVIF 的任务定位

红外与可见光图像融合(IVIF)的目标:

给定一对 IR / VIS 图像,生成一张融合图像 F,使其包含:

- VIS 的纹理与结构信息

- IR 的显著目标与轮廓信息

同时兼顾视觉效果(给人看)与感知性能(给机器看)。

IVIF 早期主要是作为图像增强技术,服务于夜视、监控等“人眼观察”;

近年来逐渐变成多模态感知的前端模块,服务于:

- 目标检测(行人 / 车辆)

- 语义分割(道路 / 建筑 / 行人)

- 目标跟踪、人群计数、显著目标检测、深度估计等

1.3 这篇 TPAMI 综述在做什么?

论文的核心点不是简单罗列方法,而是提出了一个三维视角:

数据兼容性(Data Compatibility)

- 未配准图像如何处理?

- 对抗样本 / 传感器扰动如何应对?

融合方法(Image Fusion)

- AE / CNN / GAN / Transformer / 通用融合框架

- 损失函数和网络架构如何演化?

任务适配(Task Adaption)

- 如何为检测 / 分割等下游任务设计“任务驱动”的融合网络?

- 如何评估“好看”和“好用”的平衡?

本综述整理了 180+ 种深度学习 IVIF 方法,结合大量对比实验、表格与可视化结果,给出了当前研究现状与未来趋势。

2. 任务定义与整体流程

2.1 IVIF 任务定义

给定一对由不同传感器采集的 IR / VIS 图像:

- 记为:(I_{IR}, I_{VIS})

- 任务:学习一个融合算子 ( \mathcal{F}(·) ),得到融合图 ( I_F = \mathcal{F}(I_{IR}, I_{VIS}))

要求:

- 信息量不低于任一模态;

- IR 中的热目标在融合图中清晰可见;

- VIS 中的纹理、结构细节得到较好保留;

- 融合图既可供人眼理解,又利于下游任务网络(检测 / 分割等)处理。

2.2 实际应用中的两大核心难点

未必有“完美配准”的数据

- 不同相机视角、安装方式、分辨率都不一样;

- 精准像素级对齐很难,特别是移动平台、动态场景。

也就是说,一般没有红外与可见光两张图重合起来完美重合的情况,会有一些偏差。

很多方法只优化“图像质量”,忽视“任务表现”

只看 MI / VIF / AG / SF 等融合指标;

但在目标检测 / 语义分割等任务上表现平平甚至退化。

正因如此,我们需要“任务驱动的融合”:在训练时就把 YOLO / SegFormer 等网络拉进来一起优化。

2.3 从数据到任务的完整流程

可以将上图抽象成三步:

数据兼容性 → 融合网络 → 任务网络

- Data:IR/VIS 图像可能未对齐、含噪声、甚至遭到对抗攻击,需要配准 / 校正 / 防御(这里比如随机在红外或可见光图像上挖去一块,模型可能会错误地放大这部分错误,因此要进行防御);

- Fusion:把数据映射到融合图像或多模态特征空间;

- Task:检测、分割、SOD、计数、深度估计等感知任务。

3. 文献综述:方法、任务与数据兼容性

本节是组会的主要部分,按三条线讲:

- 用于视觉增强的融合方法(AE/CNN/GAN/Transformer);

- 面向应用任务的融合(检测 / 分割 / 其他);

- 针对数据兼容性的未配准、通用融合框架与对抗攻击。

图4. 包含典型融合方法的分类桑基图。

3.1 用于视觉增强的融合方法

假设数据已经对齐,目标是“图像本身要好看、信息量大”。

这类方法大多遵循统一 pipeline):

特征提取(Encoder / Backbone)

特征融合(Fusion Rule / Attention)

图像重建(Decoder / Generator)

3.1.1 基于自编码器(Auto Encoder)的方法

基本范式

预训练自编码器 AE:

- 可以用 VIS 图(单模态)或 IR/VIS 图对(多模态)进行训练;

- AE 学到“如何从特征重建图像”。

图像重建(推理阶段):

- IR / VIS 分别通过共享的 Encoder 得到特征 (F_{IR}, F_{VIS});

- 按某种融合规则得到 (F_{Fuse});

- Decoder 将 (F_{Fuse}) 重建为融合图。

核心问题:哪种“融合规则”。

(a)融合规则改进

DenseFuse

- Encoder:多层稠密卷积,提取多尺度特征;

- Decoder:对称结构重建;

- 提出两类经典融合策略:

- Add:(F = F_{IR} + F_{VIS})

- L1-based Softmax:按特征 L1 范数计算权重,显著响应权重更大;

- 用像素重建损失(L2)+ SSIM 保证结果接近源图。

MFEIF

- 多尺度特征提取 + 边缘引导注意力;

- 在融合时给边缘位置更高权重,让细节更清晰。

SFAFuse / SEDRFuse 等

- 自监督策略 + 注意力加权;

- 用更多“显著性 / 结构信息”引导融合规则,而非简单加权或 max。

(b)网络架构创新

RFN-Nest

- 引入残差融合网络(RFN),把“融合规则”本身做成一个小网络;

- 整体结构类似 U-Net++ 的嵌套连接,更利于多尺度信息流动;

- 关注在“保护结构不破坏 + 增强细节”。

Re2Fusion

- 密集残差 + 双非局部(Non-local)模块;

- 一个 Non-local 看“同模态内部长程关系”,另一个看“跨模态互补关系”。

SMoA

- 基于 NAS 自动搜索编码器结构;

- 学到“适合 IVIF 的特征层次分布”,配合显著性权重作为融合规则。

现有的 AE 方法可分为两类:

融合规则和数据集成方面的增强,旨在改进多模态特征合成。

网络架构方面的创新,包括引入新层和修改连接。

3.1.2 基于 CNN 的方法

当前数量最多的一类。此类算法的关键优势在于它们能够从数据中自主学习复杂的高级特征。

仍然遵循三步:特征提取 → 融合 → 重建,区别在于:

- 是否由优化模型展开(Optimization-inspired);

- 损失函数如何设计(Loss-driven);

- 网络结构如何堆叠(Architecture)。

(1)优化驱动 CNN(Optimization-inspired)

思想:把传统的优化模型或变分模型“展开”为网络,每一层对应一次迭代。

LRRNet(低秩表示 + TPAMI)

- 假设图像可以分解为:低秩结构 + 稀疏细节;

- 原公式需要解一个带低秩约束的优化问题;

- 作者把迭代求解步骤写成可学习的网络模块(unrolling):

- 每一层更新低秩分量 / 稀疏分量 / 拉格朗日乘子;

- 优点:结构有清晰物理含义,可解释性强。

BIMDL(双层优化)

- 外层:控制“基础层 / 細节层”如何分解;

- 内层:在给定分解的情况下,优化融合图的重建误差;

- 通过双层目标,分别约束结构与纹理表示。

AUIF(算法展开)

- 将变分模型中的低频 / 高频项分成两个分支;

- 使用卷积模块模拟原本的梯度下降 / 迭代规约过程;

- 实际效果:既平滑噪声,又保留清晰边缘。

优化驱动 CNN 的共同特点:

“每一层做一小步优化”,有可解释性,而且适合写理论/推导。

(2)损失函数驱动(Loss is almost everything)

无监督 IVIF 没有 GT 融合图 → 损失函数几乎决定模型上限。

PIAFusion(光照感知损失)

- 引入子网络预测场景光照图 (L(x));

- 在暗区更信 IR、在亮区更信 VIS;

- 在总损失中加入光照加权项,使模型学习到“不同区域依赖不同模态”。

STDFusionNet(显著性引导损失)

- 先用显著性检测网络得到 IR 中“热目标掩模”;

- 在 Loss 中对这些区域加大权重:

- 目标区域:更强调 IR → 保证目标突出;

- 非目标区域:平衡 IR/VIS → 保证背景自然。

PSFusion(Progressive Semantic Injection)

- 用语义分割网络抽取 semantic feature;

- 通过特征层渐进注入 + 语义一致性损失,使融合图保留更多语义边界(路 / 车 / 人)。

PromptF / FILM(语义 / 感知损失)

- 利用视觉-语言模型或大语言模型生成文本提示(prompts);

- 将这些“语义提示”编码成向量,引入感知损失,引导网络在特定语义区域加强细节;

- 兼顾视觉效果与识别性能。

实际上,很多方法网络”长得“差不多,真正区别在损失函数怎么写。

(3)架构创新(Architecture matters)

IGNet(CNN + GNN)

- CNN 提取多尺度特征 → 构建图结构(像素块作为节点);

- 通过图神经网络做跨模态信息传播;

- 适合建模远距离关联和跨模态一致性。

Dif-Fusion / DDFM(扩散模型)

- 构建“融合图的扩散过程”:从噪声逐步还原;

- 通过正向加噪 + 逆向去噪学习图像分布;

- 优点:视觉质量高,细节自然;

- 缺点:计算极其昂贵,不适合实时部署。

SMoA / TIMFusion / 隐式架构搜索(IAS)

- SMoA:构建“超网络”,用 NAS 自动搜索子结构(编码器 / 融合模块);

- TIMFusion:在搜索目标中直接融合“视觉性能 + 硬件延迟”,找到既准又快的结构;

- 体现出“自动化结构设计 + 硬件感知”的新趋势。

在基于 CNN 的图像融合方法领域,有三种创新方法脱颖而出:

受优化启发的 CNN 方法利用迭代集成和可学习模块来提高融合效率。

修改损失函数对 IVIF 任务中的无监督学习结果至关重要。

架构改进侧重于优化网络设计,神经架构搜索(NAS)是一种用于结构优化的专门方法。

3.1.3 基于 GAN 的方法

GAN 天然适合“无监督分布建模”,与 IVIF 相当契合。GAN在无需标签监督的情况下对数据分布进行建模方面已证明其有效性。这种无监督方法自然适用于 IVIF 任务,GAN 已成为主要的方法之一。:

- 生成器 G:输入 IR/VIS,输出融合图;

- 判别器 D:判断融合图像分布是否接近某模态或多模态分布。

但也存在典型问题:

- 训练不稳定;

- 易出现伪影;

- 模态不平衡(只像 VIS 或只像 IR)。

(1)单判别器(Single Discriminator)

单判别器方法利用原始 GAN ,将融合图像约束为与一种模态相似。

FusionGAN

- 生成器包含两条路径:

- 对比路径:保 IR 强度分布;

- 梯度路径:保 VIS 纹理细节;

- 判别器只判断“像不像 VIS”;

- 问题:往往导致融合结果偏向可见光,弱化热目标。

- 生成器包含两条路径:

GANMcC

- 将判别器改为多分类:区分 IR / VIS / Fused 等类别;

- 希望通过多分类方式减轻模态不平衡;

- 本质仍为单判别器,无法对不同模态施加独立约束。

单判别器的普遍问题:监督信号偏向单模态,难以同时保留 IR + VIS 两端的优势。

(2)双判别器(Dual Discriminators)

双判别器方法利用两个判别器来平衡典型的模态信息。···································································

DDcGAN

- 生成器 G 输出 F;

- 两个判别器:

- (D_{VIS}):判断 F 是否“像 VIS” → 对纹理敏感;

- (D_{IR}):判断 F 是否“像 IR” → 对热目标和强度敏感;

- 在对抗训练中逼迫 G 在两种模态间折中,兼顾纹理与目标。

ICAFusion

- 在生成器中加入交互注意力(Interactive Cross Attention)模块;

- 强调跨模态信息交互,而非简单拼接或加权;

- 依然是 G + 2D 的框架结构。

FreqGAN

- 采用小波分解,将图像拆成不同频带;

- 判别器在频域中约束各频带特征,使高频细节和低频结构分别得到合理保留。

总结:GAN 系方法在视觉效果上很亮眼,但

在检测 / 分割等任务上的提升并不必然优于 CNN / Transformer 系。

3.1.4 基于 Transformer 的方法

核心:用自注意力建模长程依赖 + 跨模态交互。

总体上的趋势还是:CNN + Transformer 混合结构:

- CNN:提局部细节(边缘、纹理);

- Transformer:提全局上下文和跨模态关系。

代表方法

IFT / SwinFusion / YDTR / TGFuse / DATFuse

- 典型结构:

- 前几层:卷积提局部浅层特征;

- 后几层:Transformer 块(window / global attention)建模长程依赖;

- SwinFusion:用 Swin Transformer 构造两种注意力模块(自注意力 + 跨模态注意力);

- YDTR:Y 型结构,一路偏局部细节,一路偏全局上下文。

- 典型结构:

DATFuse

- 双重注意力:同时处理空间注意力与通道注意力;

- 特别强调“重要区域 + 重要通道”的选择性放大。

CMTFusion / CDDFuse

- CMTFusion:跨模态 Transformer,显式去冗余,保留互补信息;

- CDDFuse:双分支 CNN-Transformer 结构,两路分别分解模态相关与模态无关特征,借助 Restormer 风格模块实现无损信息传递。

Text-IF / PromptF / FILM

- Text-IF:引入文本描述(例如“车”“行人”),做文本引导的退化感知融合;

- PromptF:通过视觉-语言模型生成语义提示,指导融合网络关注特定重要区域;

- FILM:利用 ChatGPT 等从图像生成语义文本,再用跨注意力把文本信息注入融合过程。

优缺点小结

优点:

- 长程依赖建模能力强;

- 跨模态交互更充分;

- 指标(MI/VIF/结构保持等)往往更好。

缺点:

- 模型参数多,FLOPs 高;

- 显存占用大,对端侧部署不友好;

- 需要结合蒸馏 / 剪枝 / NAS 等做轻量化。

3.2 面向应用的融合(任务适配)

说人话,这一节就是体现“从给人看 → 给机器看”的地方。

论文重点讲了两类任务:

- 目标检测(Detection-aware Fusion);

- 语义分割(Segmentation-aware Fusion)。

此外还提到跟踪、人群计数、显著性检测、深度估计等任务,这些与 IVIF 关系略弱,因此本节简略带过。

3.2.1 面向目标检测的融合

背景:有了像 M³FD 这样同时包含 IR/VIS 图像对和目标检测标注的数据集,可以直接让检测网络参与融合网络训练。

(1)TarDAL:双层优化的目标感知融合

Liu 等人率先探索了图像融合和目标检测,提出了 TarDAL 方法,并构建了最大的多模态目标检测数据集。TarDAL 提出了一种双层优化公式来建模两个任务之间的内在关系,并展开优化以构建目标感知的双层学习网络。

贡献:

- 提出最大的多模态目标检测数据集 M³FD;

- 提出 TarDAL(Target-aware Dual Adversarial Learning)。

双层优化思想:

- 下层(fusion-level):给定 IR/VIS,输出融合图;

- 上层(detection-level):在融合图上训练检测网络(类似 YOLO),最大化检测 mAP;

- 把两个层级的优化过程展开成一个可训练网络。

关键点:

- 利用视觉显著性图(VSM)强调 IR 中的热目标;

- 损失函数中对目标区域加权,保证小目标(远处行人)不被淹没;

- 实验结果:在 M³FD 上 mAP 全面领先,尤其在小目标和退化场景(雾/雨/强光)上优势明显。

(2)DetFusion:检测驱动注意力指导融合

Zhao 等人引入元特征嵌入以实现目标检测和图像融合之间的兼容性。Sun 等人提出了令人瞩目的 DetFusion 方法,利用检测驱动的信息通过共享注意力机制指导融合优化。目标感知损失在从目标位置学习像素级信息方面也起着关键作用。

- 结构:

- 融合网络 + 检测网络部分共享 backbone;

- 检测分支产生的 attention map 回馈给融合分支;

- 思路:

- 检测网络告诉融合网络“哪里是车 / 人 / 重要目标”;

- 融合网络在这些位置分配更多注意力与容量;

- 效果:

- 在不大幅增加计算量的前提下,提高检测性能;

- 在视觉上也偏向强化目标区域的对比度和边界。

(3)MoE-Fusion:混合专家(Mixture of Experts)

Cao 等人提出了 MoE - Fusion 方法,集成了局部 - 全局专家混合模型来动态提取各自模态的有效特征。这种对局部信息和全局对比的动态特征学习证明了目标检测的有效性。

- 框架:

- 设置多个“专家”:IR 专家、VIS 专家、局部专家、全局专家等;

- 门控网络依据输入内容动态分配专家权重;

- 优点:

- 自适应选择“此处更信 IR 还是 VIS”;

- 同一模型可适应多场景(昼夜、雾天、复杂背景)。

(4)MetaFusion:元特征嵌入

Zhao 等人提出了 MetaFusion 方法,利用来自目标检测的元特征嵌入来对齐语义和融合特征,实现有效的联合学习。

- 想法:

- 从检测网络中抽取“元特征”(例如类别、尺度、置信度等);

- 将这些 meta-feature 作为额外输入嵌入融合网络;

- 作用:

- 元特征提供了高层语义指导;

- 促使融合结果在语义上更“合检测器口味”。

(5)不显式生成融合图的多模态检测方法(对照)

在此论文中也提到一些不生成融合图,只做特征级多模态检测的工作:

- 通常结构:

- IR/VIS 双流编码器;

- 中间若干层做特征级融合(注意力 / 特征对齐 / 概率集成等);

- 最后单个检测头预测类别与框。

这些方法从“检测任务”出发看问题,而本文综述更多是从“通用融合 + 下游任务”的角度出发。

换而言之,这些方法只关心结果,不生成融合图,直接做多模态检测,只要任务完成得好就行。

3.2.2 面向语义分割的融合

目标:使融合图对语义分割任务友好,提高 mIoU/mAcc。

(1)SeAFusion:融合 + 分割级联 + 语义损失

SeAFusion 将图像融合与分割任务级联,通过基于循环的训练引入语义损失以增强融合的信息丰富度。

- 结构:FusionNet → SegNet 级联;

- 训练:

- 用分割网络的预测与 GT 计算分割损失(比如交叉熵 + mIoU);

- 把这部分损失反向传到 FusionNet;

- 作用:

- 分割网络像“老师”一样指导融合网络:

- 哪些边界要更清晰;

- 哪些区域需要更高对比度。

- 分割网络像“老师”一样指导融合网络:

(2)SuperFusion:多功能配准 + 融合 + 语义感知框架

Tang 等人提出了 SuperFusion,这是一个用于多模态图像配准、融合和语义感知的通用框架。

- 同时解决三个问题:

- 未对齐图像的配准(估计双向形变场);

- IR/VIS 信息融合;

- 语义感知(通过语义分支提供高层约束)。

- 特点:

- 在未对齐场景下表现突出;

- 是“数据兼容 + 融合 + 任务适配三合一”的代表工作。

(3)PSFusion:渐进式语义注入

PSFusion 在特征级别引入渐进式语义注入,考虑了融合的语义需求。它还表明,在计算资源较少的情况下,图像级融合在感知任务中与特征融合具有可比的性能。

- 思路:

- 在特征层(而不是图像层)注入语义特征;

- 分割网络多个层级的语义特征分别注入融合 backbone 的不同 stage;

- 实验观察:

- 在算力受限时,“图像级融合 + 单模态分割”在性能上可以接近“特征级多模态分割”;

- 对工程实现有参考价值(便于复用现成分割器)。

(4)SegMiF:双任务相关性的联合学习

Liu 等人提出了 SegMiF,利用双任务相关性来提高分割和融合性能,引入分层交互注意力进行细粒度任务映射,并收集了这些任务的最大全时基准数据集。

- 特点:

- 同时看“融合任务”和“分割任务”的相关性;

- 用分层交互注意力模块进行双向特征交换:

- 融合分支获得语义信息;

- 分割分支利用更丰富的结构与纹理特征;

- 数据:

- 作者构建了目前规模最大的融合 + 分割联合数据集 FMB(14 类),用于性能评测。

(5)MRFS / CAF / TIMFusion 等统一感知驱动框架

MRFS:

Zhang 等人提出了 MRFS,这是一个耦合学习框架,通过相互强化集成图像融合和分割,实现了增强的视觉质量和更准确的分割结果。

- 耦合学习框架,强调“融合结果 ↔ 分割结果”的互相强化;

CAF:

- 自动搜索适合检测 / 分割任务的损失组合;

- 减少人工调 loss 的工作量;

TIMFusion:

- 用隐式架构搜索获得硬件友好、任务性能优良的融合网络;

- 一套结构适配多种下游感知任务。

3.2.3 其他感知任务(略)

这些任务与 IVIF 是“应用层面的延伸”,与任务本身不完全以 IVIF 为核心,因此简略描述:

RGB-T 目标跟踪

- 通过像素级 / 特征级 / 决策级融合 IR/VIS 提高跟踪鲁棒性;

- 抵抗遮挡、弱光、背景干扰。

人群计数(Crowd Counting)

- 利用多模态信息区分“人”和“背景热源”;

- 在高密度、遮挡严重场景下提高密度估计精度。

显著目标检测(SOD)

- 如 IRFS:将融合和显著性检测做成多任务框架;

- 通过交互增强使显著目标轮廓更准确。

深度估计 / 其他

- 使用光谱转换 / 风格迁移处理复杂光照;

- 辅助估计深度或其他几何信息。

3.3 数据兼容性:未配准、通用融合与对抗攻击

理论上的红外和可见光图像的融合是美好的,但是现实是残酷的:未对齐、带噪声、甚至遭攻击。

3.3.1 未配准(Misaligned)图像的融合

大致分为两条路线:

- 基于风格迁移的“伪标签”方法(Style Transfer-based)

- 基于潜在空间的模态无关特征(Latent Space-based)

(1)基于风格迁移的配准 + 融合范式

生成伪标签,将多模态配准转换为单模态配准

典型流程:

- MTN(模态转换网络):

- 将 VIS → IR 风格 或 IR → VIS 风格,生成“伪标签图像”;

- STN(空间变换网络):

- 学习源图像与伪标签之间的空间变形场;

- 完成配准后,再用常规融合网络处理。

代表方法:

Nemar / UMIR

- Nemar:提出使用单模态度量指标训练多模态配准网络;

- 双向训练策略:

- 先配准再转换;

- 先转换再配准;

- 目的是保证伪标签既风格接近目标模态,又几何结构可靠。

UMFusion

- 关注“未配准导致的重影伪影”;

- 引入跨模态生成-配准范式:

- 生成伪标签减少模态差异;

- 联合学习配准与融合,缓解重影。

RFNet

- 把配准与融合设计成互相促进的两个子任务:

- 粗配准 → 融合 → 精配准 → 再融合;

- 在配准过程中不断利用融合结果提升一致性。

- 把配准与融合设计成互相促进的两个子任务:

优点:

- 利用单模态指标做监督,训练相对稳定;

- 宜于处理较大视角差异。

缺点:

- 模态转换质量会直接影响最终效果;

- 有可能引入风格偏差(比如颜色失真)。

(2)基于潜在空间的模态无关特征

构建模态无关的特征空间,将多模态图像特征映射到共享空间,并利用共享特征预测变形场

核心思想:

- 提取 IR / VIS 的“公共特征”,让两种模态在“共享空间”对齐;

- 在共享特征空间中预测形变场,再反向约束原图配准。

代表方法:

MURF

- 强调模态无关特征对配准的重要性;

- 采用粗配准 + 精配准两阶段策略:

- 粗配准:对比学习约束共享特征的分布;

- 精配准:在共享空间上细化形变参数;

- 融合与配准互相扶持。

SuperFusion

- 前面已经介绍:融合 + 配准 + 语义一体化;

- 在光度一致性和端点误差约束下估计双向形变场;

- 对几何扭曲修正效果好。

ReCoNet

- 递归修正网络;

- 多次迭代补偿几何扭曲,逐步减轻重影。

SemLA / RFVIF

- SemLA:在各阶段显式嵌入语义信息,以辅助配准;

- RFVIF:针对融合质量做特别优化。

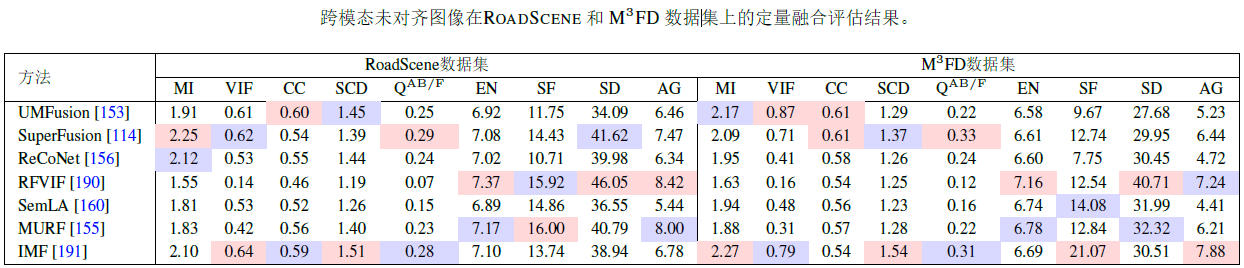

定量结论(基于 RoadScene / M³FD):

- 有真实变形场监督的 SuperFusion 在基于参考的指标(、、、)最强;

- 风格迁移系列(UMFusion / IMF)基于参考指标次优;

- 潜在空间系列(RFVIF / SemLA / ReCoNet / MURF)在无参考指标( / / / )上通常更好 → 纹理丰富。

说明:配准质量、融合质量、纹理丰富度、语义表现等之间存在复杂 trade-off。

3.3.2 通用融合框架(General Fusion)

目标:一套框架尽可能适配多种模态、多种任务:

- IR/VIS;

- 医学多模态(CT/MRI/PET 等);

- 遥感多光谱 / 全色等。

为了解决多模态图像融合中通用融合框架的核心问题:

损失函数增强:创新集中在先进的损失度量上,以提高图像质量。

架构创新:升级旨在更好地进行特征提取和提高网络效率。

(1)损失函数创新方向

U2Fusion / FusionDN / PMGI / IFCNN / SDNet 等

- 从信息论、图像质量评价(IQA)、边缘/梯度等角度设计通用损失;

- 使得同一套损失对多种任务(IVIF、医学融合、曝光融合…)都适用。

CoCoNet

- 提出特征级对比学习损失;

- 通过拉近“好融合样本”与“源图像 / 参考”的距离,拉远“差融合样本”;

- 在无参考指标(EN / SF / AG)上表现非常突出。

EMMA

- 引入伪感知模块(pseudo-perceptual module),通过自监督学习模拟人类感知;

- 再配合感知损失约束融合结果。

FILM

- 利用 LLM 生成语义提示,并通过跨模态注意力引导融合;

- 把“文本语义”引入通用融合框架中。

(2)架构设计方向

- 多任务共享编码器 + 任务特定解码器;

- 隐式架构搜索(IAS):

- TIMFusion 等通过搜索得到既兼顾视觉(指标)又兼顾硬件(延迟)的结构;

- 多层次分解(基础层 / 细节层)+ 双层优化(BIMDL 的思路)。

3.3.3 对抗攻击与鲁棒性

对抗攻击是指在图像上添加难以察觉的扰动,很容易欺骗神经网络的估计。网络在多模态视觉下对抗攻击的脆弱性尚未得到广泛研究。考虑到多模态分割在对抗攻击下的鲁棒性,PAIFusion 率先利用图像融合来增强鲁棒性。该工作通过详细分析确定了脆弱的融合操作和规则。

意义:对确保现实世界应用的鲁棒性和安全性至关重要。

问题背景

- 多模态视觉网络也会被对抗攻击欺骗;

- 如果 IR 或 VIS 某一模态被添加微小扰动,融合结果和下游任务很可能出现严重错误;

- IVIF 如何在这种情况下保持鲁棒性,是刚刚起步的方向。

图7. 数据兼容的红外与可见光图像融合(IVIF)方法的基本分阶段流程。

PAIFusion

- 首个系统分析“融合操作 / 规则在对抗攻击下的脆弱性”的工作;

- 利用图像融合增强多模态分割网络在对抗攻击下的鲁棒性;

- 分析了哪些融合模块容易被攻击、哪些更稳定。

未来研究:

设计“对抗鲁棒融合网络”,即使 IR/VIS 中有一模态被攻击,融合结果仍可用。

3.4 架构总结与讨论

论文把现有深度融合网络按结构复杂度和设计思路分为四类:

使用现有架构

- 直接使用 ResNet / DenseNet / U-Net 等成熟架构;

- 典型:DenseFuse、RFN-Nest 等;

- 优点:开发成本低、训练稳定。

复杂堆叠网络

- 把多种模块(残差块、注意力、Transformer、金字塔、GNN 等)堆在一起;

- 典型:Re2Fusion、CDDFuse、TGFuse 等;

- 强调极致性能,但结构复杂,难以部署。

多分支 / 多批次架构

- 为不同模态(IR/VIS)设计不同编码器;

- 常见于任务适配网络(TarDAL / DetFusion / MoE-Fusion 等)。

递归 / 扩散结构

- 使用递归网络或扩散模型逐步优化融合结果;

- 典型:ReCoNet、DDFM;

- 适合质量要求极高或序列数据,但代价是计算量巨大。

总体而言,红外和可见光图像融合的研究正朝着更复杂和精细的网络结构发展,以满足复杂的融合需求。

3.5 损失函数总结与讨论

在无监督红外和可见光图像融合领域,损失函数的设计和选择至关重要。

这些函数通常可从像素级别、评估指标和数据特征三个主要维度进行理解和分类。(本节不讨论 GAN 和扩散模型等生成模型)

在像素级别,L1 和 MSE 损失函数通过直接比较像素来评估图像相似性。SSIM 作为关键的评估指标,通过考虑图像结构和质量扩展了这一概念,反映了人类视觉感知。针对数据特征的损失函数(如图像梯度)则侧重于在融合过程中保留详细纹理。

在此基础上,出现了更复杂的损失函数变体来解决图像融合中的特定挑战。例如,在像素级别应用视觉显著性图(VSM)代表了一种创新,产生了更细致的融合效果。在评估指标层面,使用空间频率(SF)等不太常见的指标作为损失函数,强调了图像的频率特征和视觉效果,从而在保持视觉舒适度的同时实现有效融合。此外,基于复杂图像特征的损失函数(如最大化梯度或边缘提取,以及包括感知和对比损失)提供了更深入的见解和解决方案。

损失函数的设计多种多样,除了上述类型,还引入了许多专门设计的损失函数。研究人员可以根据源图像的特征和任务要求选择、组合和优化这些损失函数,推动图像融合领域的进一步发展和创新。

三大维度:

像素级损失

- L1 / MSE:直接度量像素差;

- SSIM:考虑结构 / 亮度 / 对比度,更符合人眼感知。

结构 / 特征级损失

- 梯度 / 边缘损失:保持纹理和边缘清晰;

- 频域损失(如 SF):强调细节和高频信息;

- 视觉显著性图(VSM):对显著区域赋予更大权重;

- NR-IQA(无参考图像质量评价)指标也被用作损失(FusionDN 等)。

语义 / 对比 / 感知损失

- 语义损失:利用分类 / 检测 / 分割网络的中间特征;

- 对比损失:CoCoNet、EMMA 等充分利用;

- 感知损失:基于 VGG 等预训练网络的高维特征差异;

- 任务驱动损失:检测 / 分割的任务损失直接反向训练融合网络(TarDAL、SeAFusion、SegMiF 等)。

实际做法:

通常是多种损失混合加权,通过验证集(包括感知指标)来调整权重。

4. 基准数据集与评估指标

4.1 数据集概览

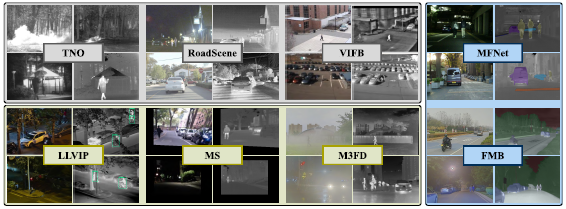

图8. 现有红外-可见光图像融合(IVIF)数据集示意图

大致分三类:

4.1.1 早期面向融合的数据集

TNO

- 军事 / 户外场景;

- 图像对数较少(261 对),分辨率较低(768×576);

- 常用作视觉效果展示与定性评估。

RoadScene

- 道路驾驶场景,包含不同天气;

- 图像数量 221 对,分辨率不固定;

- 更接近自动驾驶场景。

VIFB

- 整理多个来源数据;

- 更偏向“benchmark 性质”,用于对比传统方法。

4.1.2 目标检测数据集

MS

- 多光谱目标检测数据集;

- 主要是驾驶场景,包含 6 类目标;

- 有标注框,可用于检测任务。

LLVIP

- 监控场景,1280×720 分辨率;

- 主要关注行人检测;

- 适合做低光 / 夜间监控场景研究。

M³FD

- 当前最重要的 IVIF 检测数据集;

- 4200 对图像,1024×768 分辨率,多角度拍摄;

- 涵盖白天 / 夜晚 / 雾 / 雨等多种天气;

- 标注 6 类目标,含 3 万+ 标注框;

- 大量任务驱动方法(TarDAL / DetFusion 等)都在上面评测。

4.1.3 语义分割数据集

MFNet

- 1569 对图像,640×480 分辨率;

- 驾驶场景,8 类语义标签;

- 适用于 RGB-T 语义分割研究。

FMB

- 1500 对图像,800×600 分辨率;

- 多角度,14 类语义标签;

- 由 SegMiF 提出,专门用于“融合 + 分割”的联合评估。

4.2 评估指标

4.2.1 融合质量指标(9 个)

有参考(基于源图像):

MI(Mutual Information,互信息)

衡量源图像信息被传递到融合图的程度(信息量);

VIF(Visual Information Fidelity)

评估融合的保真度,与人类视觉系统对齐,值越高表示性能越好;

CC(Correlation Coefficient)

评估融合图像对源图像的反映程度,侧重于线性相关性;

SCD(Sum of Correlation of Differences)

衡量源图像独特信息的整合情况。CC 强调现有关系,而 SCD 关注新元素;

(基于梯度的融合质量指标)

看边缘 / 梯度细节是否得到良好保留(越接近 1 越好)。

无参考指标:

- EN(Entropy,熵):衡量融合图像中的信息内容(信息量大小)(但对噪声敏感);

- SF(Spatial Frequency,空间频率):评估细节和纹理的清晰度,值越高表示边缘和纹理信息越丰富;

- SD(Standard Deviation,标准差):从分布和对比度方面反映图像质量,对比度越高,SD 值越大;

- AG(Average Gradient,平均梯度):衡量纹理特征和细节,AG 值越高表示融合性能越好。

注意:EN / SF / AG 等指标高不一定就好,有可能是噪声多。

4.2.2 配准指标

MSE(Mean Squared Error)

测量两幅图像像素之间的平均平方差,用于评估它们的对齐程度。MSE 值越低,表示相似度越高,是图像配准和融合中的关键指标;

MI(互信息)

是图像配准中常用的相似性指标。MI 值越高,表明两幅图像对齐越好;

NCC(Normalized Cross Correlation)

是评估两幅图像中对应窗口相似性的指标,用于评价配准精度。

4.2.3 感知任务指标

语义分割

- IoU / mIoU:交并比及其类别平均;

- Acc / mAcc:像素准确率及其类别平均。

目标检测

- Precision / Recall:精确率 / 召回率;

- AP / mAP:单类 / 多类平均精度。

评估时最好把“融合指标 + 感知指标”一起看,单纯依赖 MI / VIF 容易误判。

5. 性能总结与消融对比

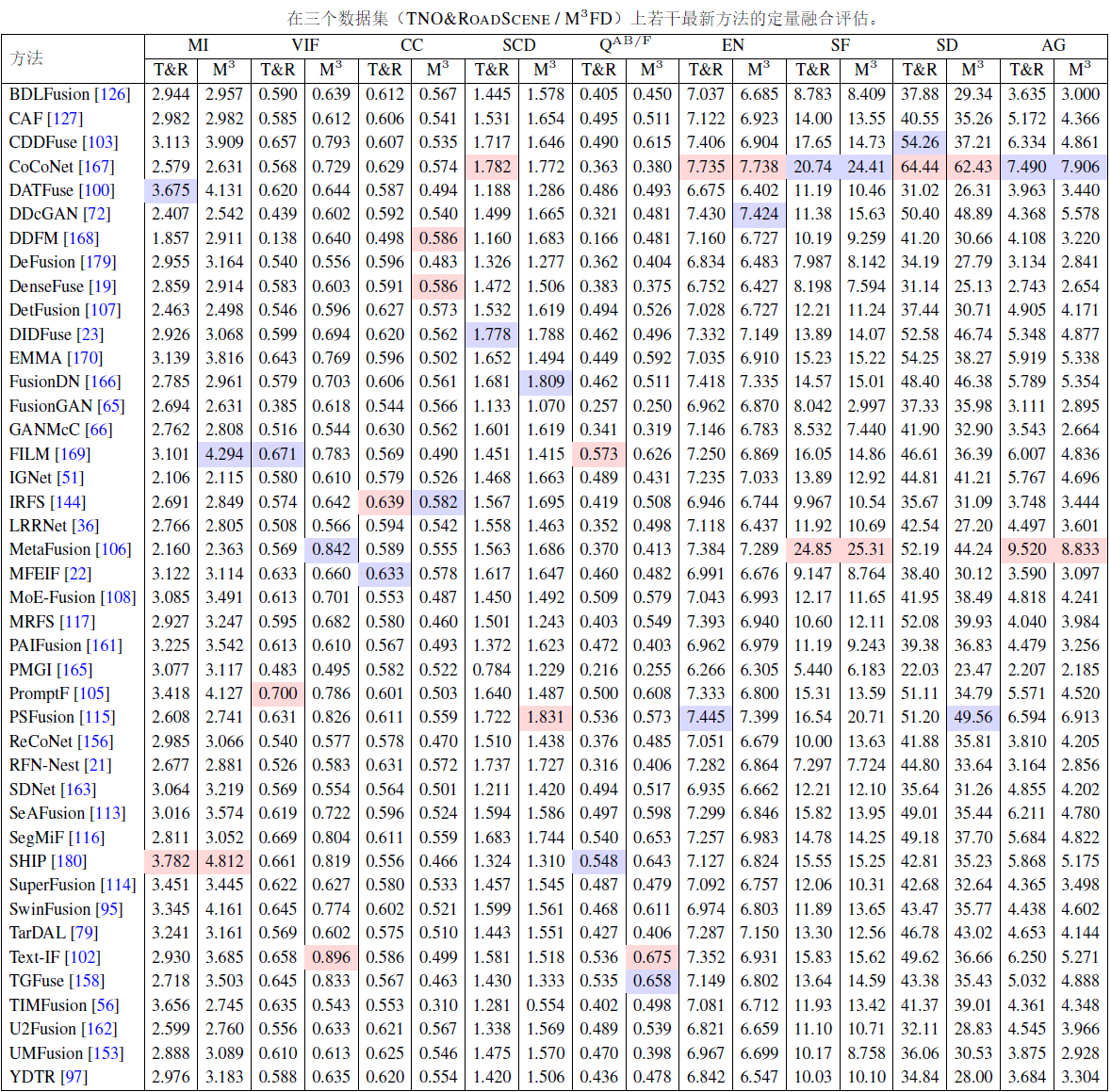

5.1 图像融合质量(TNO / RoadScene / M³FD)

定性分析

- 在 M³FD 的烟雾场景中对比多种方法:

- IGNet:为了压制烟雾,倾向 IR 模态,结果颜色失真严重;

- CoCoNet:人物和背景车都清楚,但草地区域发生明显颜色偏差;

- CAF / MoEFusion:在压制烟雾的同时,保持颜色自然。

定量分析

参考指标:

- 使用传统基于源图像损失函数的方法(如 DenseFuse 的 CC 指标)由于充分保留了源图像信息而具有显著优势;

- 针对分割进行优化的方法在视觉保真度指标(如 PromptF 的 VIF 指标)上也表现出优势;

- 原因:它们充分利用了语义信息。

无参考指标:

- CoCoNet 利用特征级对比损失优化整个训练过程,其表示能力远超传统损失函数,从而在性能上脱颖而出。

- 说明对比学习在无 GT 场景中的优势。

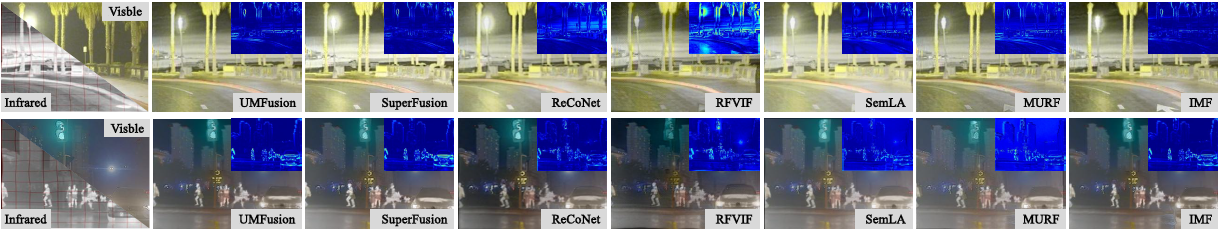

5.2 未对齐图像融合性能(RoadScene / M³FD)

定性结果

图10. 未对齐的多模态图像在两个典型图像对上的表现,与多种最新的图像融合方法进行了对比。

- SuperFusion / UMFusion / IMF 等提供了比较好的配准与融合效果:

- 有效消除结构失真与边缘重影;

- 潜在空间系列(RFVIF / SemLA / ReCoNet / MURF)仍有少量残留变形,但纹理更丰富。

定量结果

- SuperFusion 凭借真实变形场监督,在 MI / VIF / CC / Q_AB/F 上表现最佳;

- UMFusion / IMF 在大多数参考指标上次优;

- MURF 等在无参考指标(EN / SF / SD / AG)表现更好。

结论:风格迁移 + 潜在空间方法各有优劣;

若能结合两者优势,可能得到更通用的未配准融合框架。

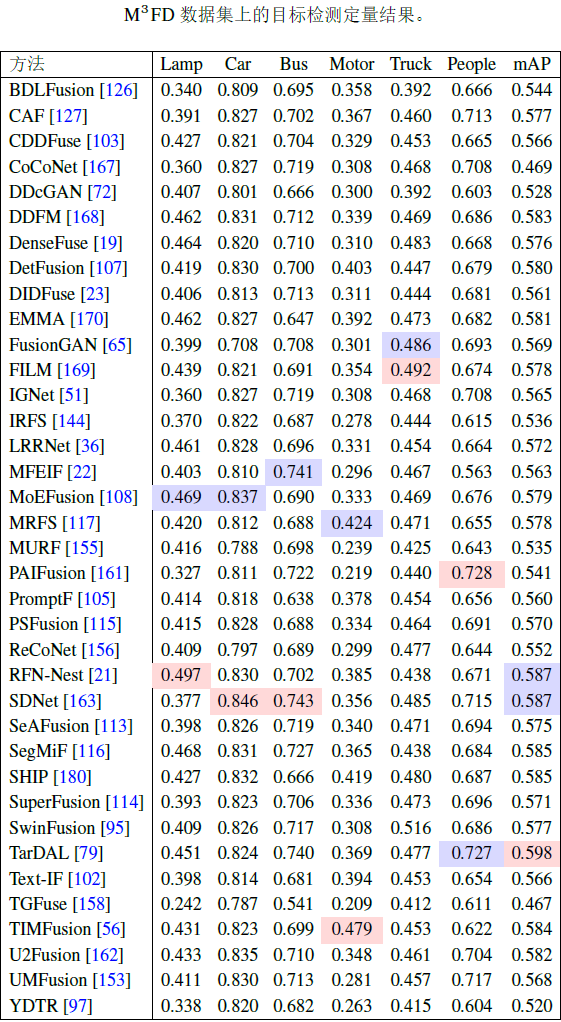

5.3 面向目标检测的融合性能(M³FD + YOLOv5)

定性对比

- 小目标场景(桥上行人 + 雾 / 强光):

- DDFM / LRRNet / ReCoNet:对比度低,小目标不突出;

- DDcGAN / IRFS:伪影明显,引入错误检测;

- TarDAL / PAIFusion:行人全部被检出,小目标召回高。

定量结果

- TarDAL 在 mAP 上最高,特别是 People、Car、Bus 等重点类别;

- TIMFusion / SegMiF / SDNet 等感知驱动方法也有不错表现;

- 一些视觉上很优的 GAN / 扩散方法,在检测任务上并不占优势。

进一步说明:“任务驱动训练的融合方法 > 只看图像指标的融合方法”。

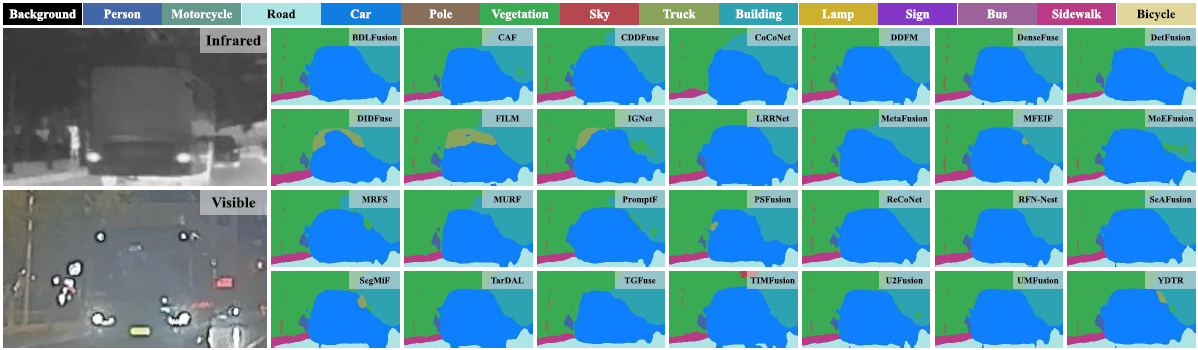

5.4 面向语义分割的融合性能(FMB + SegFormer)

统一使用先进的 SegFormer 作为基础分割器,在一致的设置下对各种先进融合方法进行训练,以衡量它们的性能。采用 FMB 数据集的官方训练集和测试集划分。

定性比较:

图12. 基于图像融合的语义分割结果与几种最先进的方法进行了比较

在这个场景中,由于能见度低,位于黑暗区域的行人对大多数方法来说都难以准确分割。同时,公交车发出的强光导致场景过曝,使得许多方法将公交车误分类为汽车,且无法捕捉其完整轮廓。这些挑战凸显了处理极端光照条件场景的持续困难。

定量比较:在表 6 中,我们报告了语义分割任务的数值结果。

实验设置:

- 采用 SegFormer 作为统一分割器;

- 各融合方法先生成融合图,再用融合图训练 SegFormer;

- 使用 FMB 官方划分训练 / 测试。

观察结论:

- MoEFusion / DetFusion / SegMiF / MRFS 等任务驱动方法在 mIoU / mAcc 上表现最优;

- 单纯视觉驱动的融合方法在极端光照(黑夜 / 强光)场景的分割边界上有明显误差;

- 再次验证:语义信息(分割 / 检测)对融合网络设计有直接帮助。

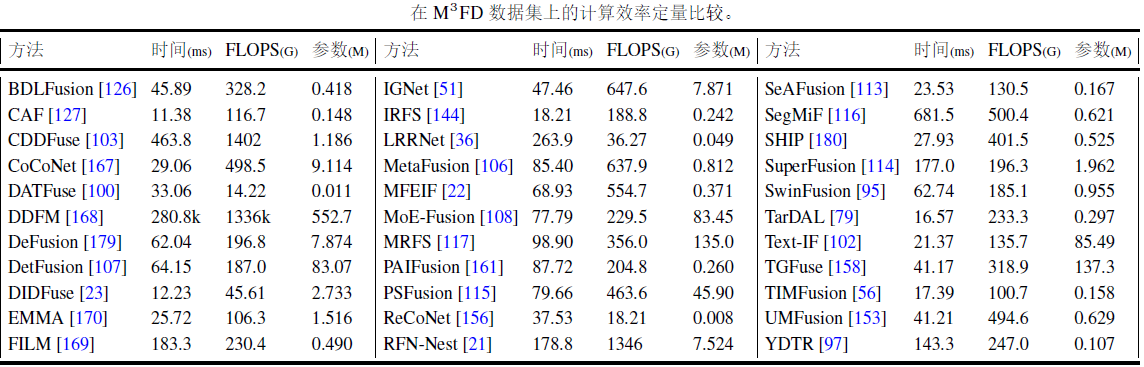

5.5 计算效率与资源消耗

论文统计了在 M³FD 上处理 10 张 1024×768 图像的三项指标:

- 运行时间(ms)

- 参数量(M)

- FLOPs(G)

总体趋势:

- DenseFuse / U2Fusion 等早期方法结构简单,速度最快,参数最少,但性能略落后;

- Transformer / 扩散模型(如 DDFM)计算开销巨大,运行时间可达数十万 ms,不适合实时应用;

- TIMFusion 借助隐式架构搜索,在速度与性能间做了一个比较好的平衡;

- 任务驱动方法通常比纯视觉优化方法稍重,但收益体现在感知任务上。

实际应用(自动驾驶 / 边缘设备)中,需要注意

“mAP / mIoU 与 FPS / 耗能之间的 trade-off”。

6. 挑战与未来研究方向

论文最后总结了若干重要开放问题,这里挑与 IVIF 强相关的部分:

6.1 未配准 & 对抗鲁棒性

- 未对齐问题:

- 当前方法只能应对“中等程度”的视角偏差;

- 大视角变化、非刚性形变、动态场景仍待解决。

- 对抗攻击:

- 多模态网络在对抗扰动下表现不明朗;

- 如何“利用多模态互补性提升鲁棒性”是值得深入挖掘的问题。

6.2 任务驱动的融合设计

- 传统:只优化融合指标;

- 未来:以 Detection / Segmentation / Tracking / SOD 等任务的表现为第一目标;

- 关键挑战:

- 怎样设计 loss 与网络结构,使视觉质量和任务性能不过分冲突;

- 怎样在多任务(检测+分割+跟踪)联合训练时避免互相干扰。

6.3 更大、更真实、更难的数据集

- 现有数据集在场景多样性、极端天气、复杂动态环境方面仍然有限;

- 期待:

- 城市 / 高速 / 隧道 / 森林 / 灾害现场等多场景大规模多模态数据;

- 带有检测 / 分割 / 深度 / SOD 等多任务标注的统一数据集。

6.4 更合理的评价体系

- 单一的 EN / SF / AG 等指标无法全面反映质量;

- 单看 mAP / mIoU 也不能体现“观感差异”;

- 未来可能需要:

- 结合 IQA / VQA / 感知指标的综合评分体系;

- 甚至“人 + 模型”的混合评价框架。

6.5 轻量化与部署友好

- Transformer / 扩散 / GAN 型网络部署到无人机、车载、智能相机时常常超出算力预算;

- 可能方向:

- 网络剪枝、蒸馏、权值共享;

- 硬件感知的 NAS / IAS;

- 面向 IR/VIS 特性的专用算子设计。